密集网络结构,每层均与前层连接,相较于残 差网络可获取更多输入信息,使较浅层网络可提取更丰富的 纹理特征。

残差块在前向传播时,浅层特征可以在深层 得到重用。反向传播时,深层梯度可直接传回浅层。

ResNet 的跳层结构一定程度上解决了网络加深出现的 原始特征的部分丢失和梯度消失问题。但是跳层结构将网 络中层数靠前的输出 x 与残差块输出直接相加,低层与高层 的特征图有较大的特征差异,可能影响网络中图像特征参数 信息更好的流动。

DenseNet[20] 不是通过加深网络层数和加宽网络结构提 升网络性能而是通过特征重用提升网络的效率。相较于 ResNet,DenseNet 提出了一个密集连接机制,每层都会与前 面所有层进行连接,作为其额外的数据输入,使较浅层的网 络也可提取更丰富的图像特征。同时 DenseNet 大量用到跳 层结构,使梯度消失问题得到优化。

密集连接将浅层的图像原始特征与深层学习的高频特 征进行叠加,在原始特征保留的基础上,添加高频纹理特征, 也可弥补网络学习过程中丢失的原始信息。

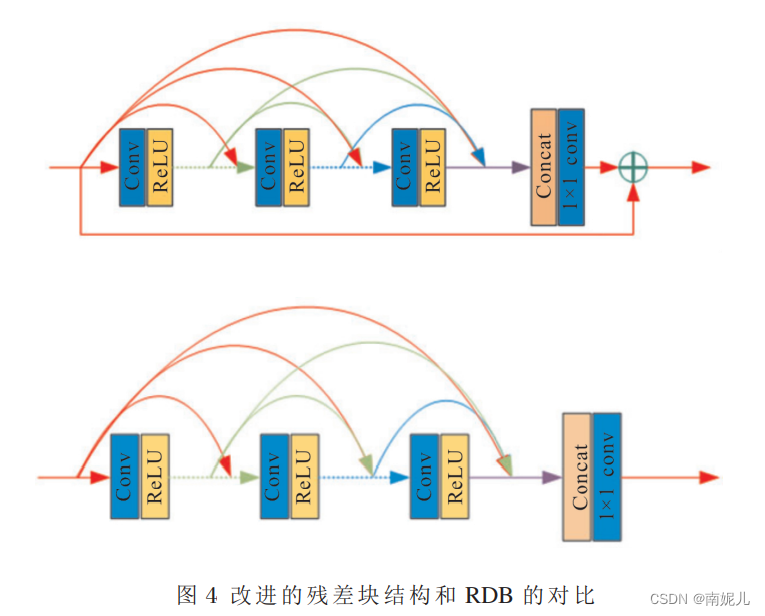

从图 4 中的结构对比可以看出,取消了残差 块的局部残差学习, 为了能够在复合网络结构中提 高模型效率,免去冗余的计算负担。

在残差块中, 采用残差块内密集串联卷积层与 局部特征融合形成了连续存储机制。 所谓连 续存 储 机制, 就是将前一层的残差块信息通过串连传递直 接传递到下一层残差块中, 此特征信息通过块内所 有卷积层后再依次传递至下一层残差块中。

充分利用了残差块中所有 卷积层, 通过卷积层的密集串接特性完全利用所有 卷积层的特征信息, 并通过残差块内部卷积层局 部 融合得到残差块特征信息; 利用残差块之间的密 集 连接性质,建立了深层卷积残差网络,通过残差块之 间的密集串接性质对残差块之间的特征信息进行 深 层融合,增强网络对图像的深层特征感知。

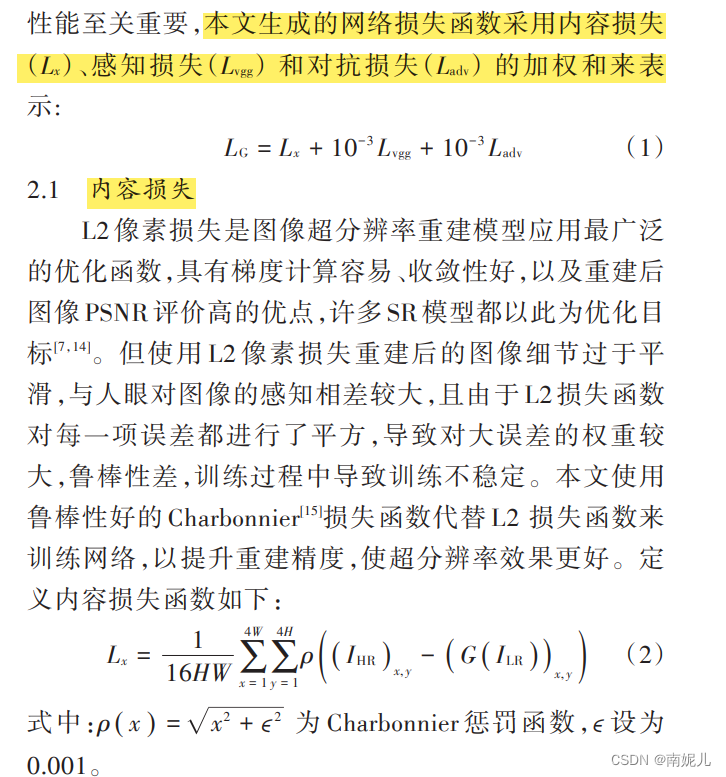

1)它们都没有对网络提取的特 征加以区别。平等对待每个通道,限制了网络的表达能力,可 能让网络在冗余的低频特征上浪费计算资源。2)深层网络所 需要训练的参数更多,等待的时间更久,如何减少参数运算量、提高模型性能也是一个重要的问题。针对上述存在的问 题,本文提出了一种基于通道注意力机制(Channel Attention mechanism,CA)和 深 度 可 分 离 卷 积(Depthwise Separable Convolution,DSC)的网络结构,由浅层特征提取块,基于通道 注意力机制的深层特征提取块和重建模块组成。首先,将低 分辨率图像送入浅层特征提取块,提取原始特征;然后,在深 层特征提取块中,在局部残差模块中加入通道注意力机制来 提取深层的残差信息,由于使用通道注意力机制会增加计算 开销,使得训练的参数增加,所以在局部残差模块中还采用深 度可分离卷积技术来减少参数运算量;最后,在重建模块,将 提取的深层残差信息和 LR的信息融合,重建 HR输出。

1)它们都没有对网络提取的特 征加以区别。平等对待每个通道,限制了网络的表达能力,可 能让网络在冗余的低频特征上浪费计算资源。2)深层网络所 需要训练的参数更多,等待的时间更久,如何减少参数运算量、提高模型性能也是一个重要的问题。针对上述存在的问 题,本文提出了一种基于通道注意力机制(Channel Attention mechanism,CA)和 深 度 可 分 离 卷 积(Depthwise Separable Convolution,DSC)的网络结构,由浅层特征提取块,基于通道 注意力机制的深层特征提取块和重建模块组成。首先,将低 分辨率图像送入浅层特征提取块,提取原始特征;然后,在深 层特征提取块中,在局部残差模块中加入通道注意力机制来 提取深层的残差信息,由于使用通道注意力机制会增加计算 开销,使得训练的参数增加,所以在局部残差模块中还采用深 度可分离卷积技术来减少参数运算量;最后,在重建模块,将 提取的深层残差信息和 LR的信息融合,重建 HR输出。

(1)为解决超分辨率重建过程中单一尺度下特征信息丢失的问题,设计了一种多尺度残差密集网络特征提取模型用于超分辨率重建过程中的特征提取。在提升算法计算效率的同时,保持重构图像的质量不发生退化。(2)为使网络进一步注意到低分辨率特征图中的冗余信息,本文通过空间注意力与通道注意力相结合的方式,使网络在不同尺度上同时注意到空间与通道上的高频信息,有效防止了信息丢失问题,提升了超分辨率重建的效果。