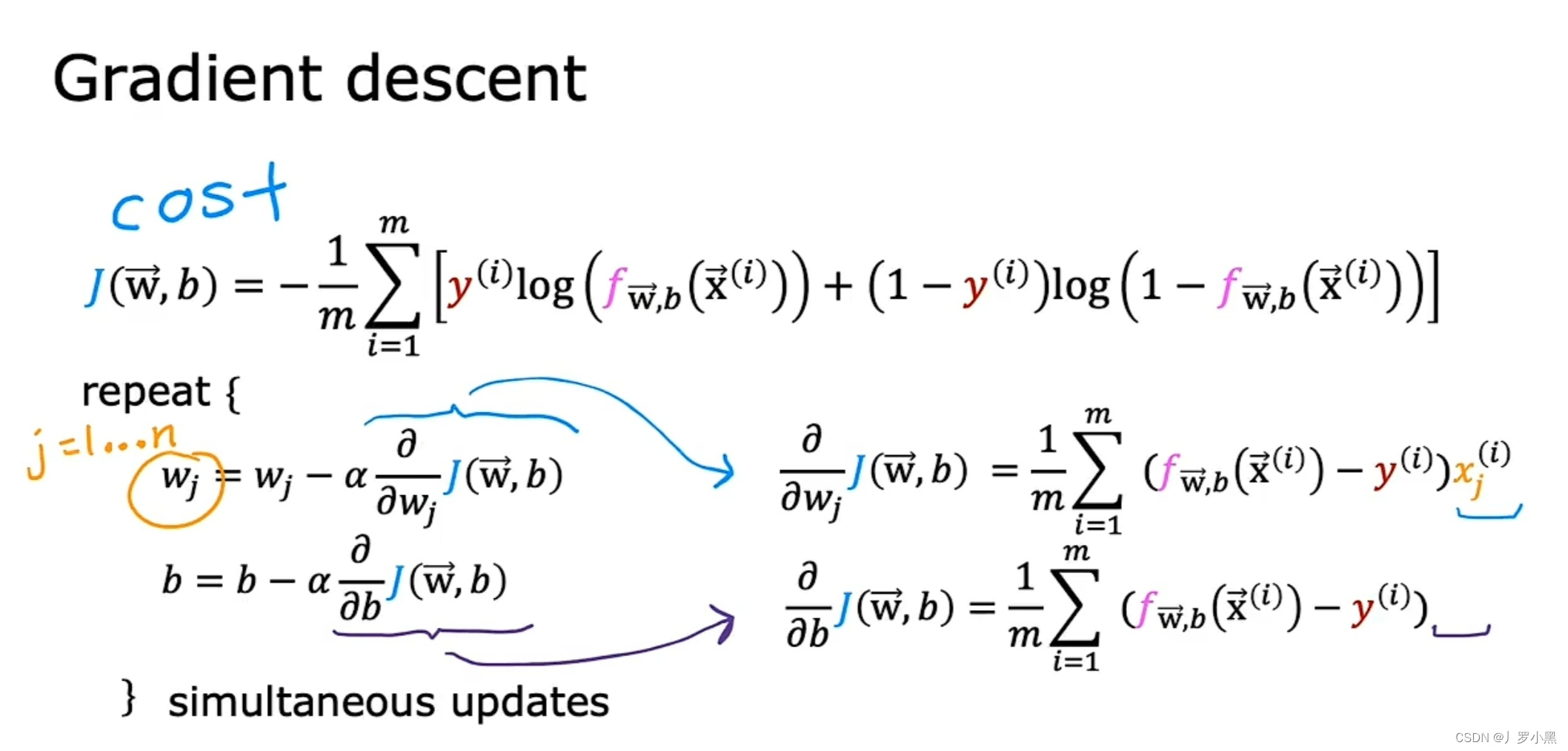

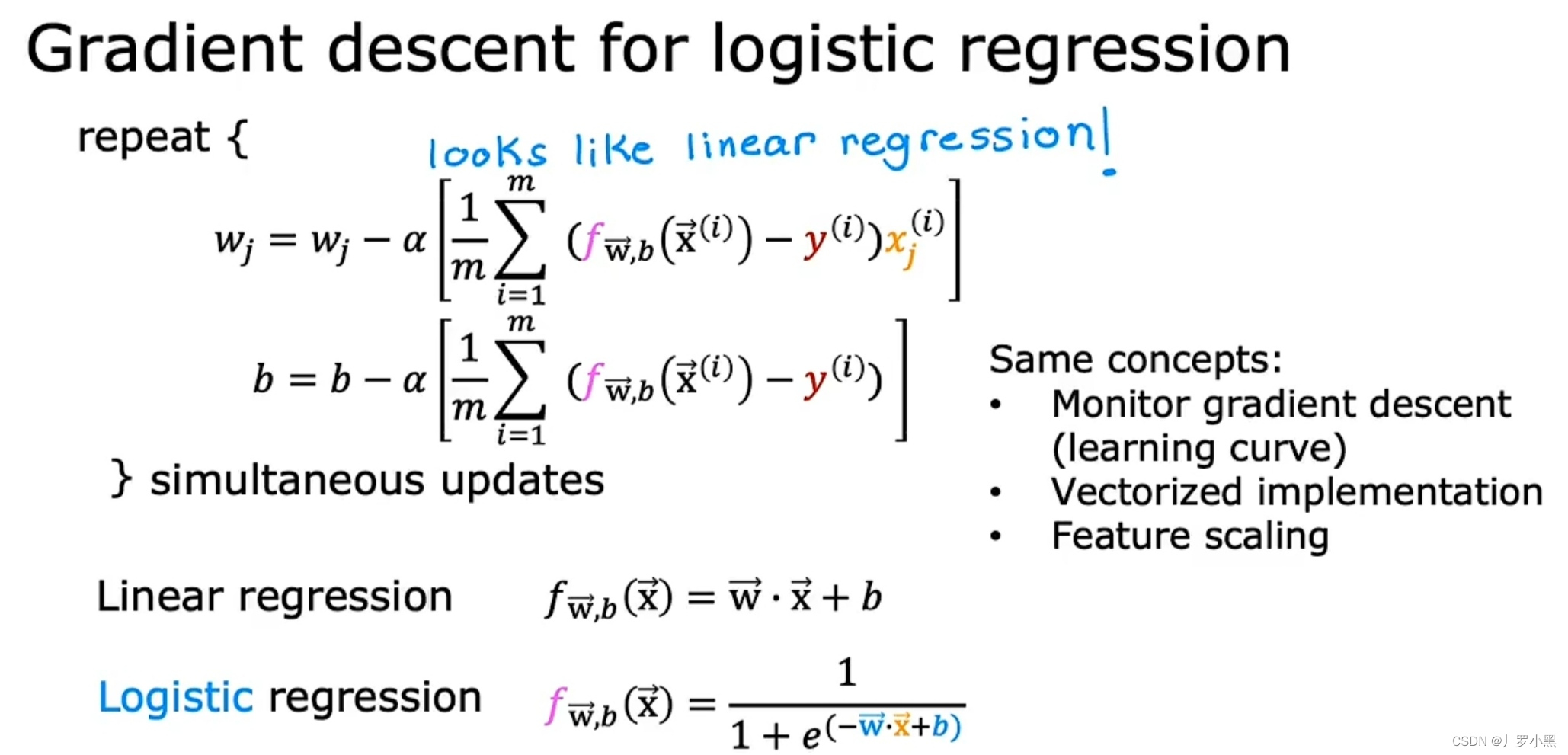

1. 逻辑回归的梯度下降

- 与多元线性回归的梯度下降相同,Wj是指从W₁到Wj中的某一项,因为逻辑回归有多个特征(变量),所以对于每一个特征X都有对应的W。而对于每一个W,梯度下降算法在每一步都要对其进行更新,且更新W时,对b也需要同时更新

- 当把偏导数项化简后,逻辑回归的梯度下降算法和线性回归的梯度下降算法看着很类似,但他们的f(x)函数不同

- 逻辑回归的梯度下降算法可以用学习曲线来监测算法是否收敛,也可以用向量化、特征缩放来简化算法的执行过程,提高算法的速度

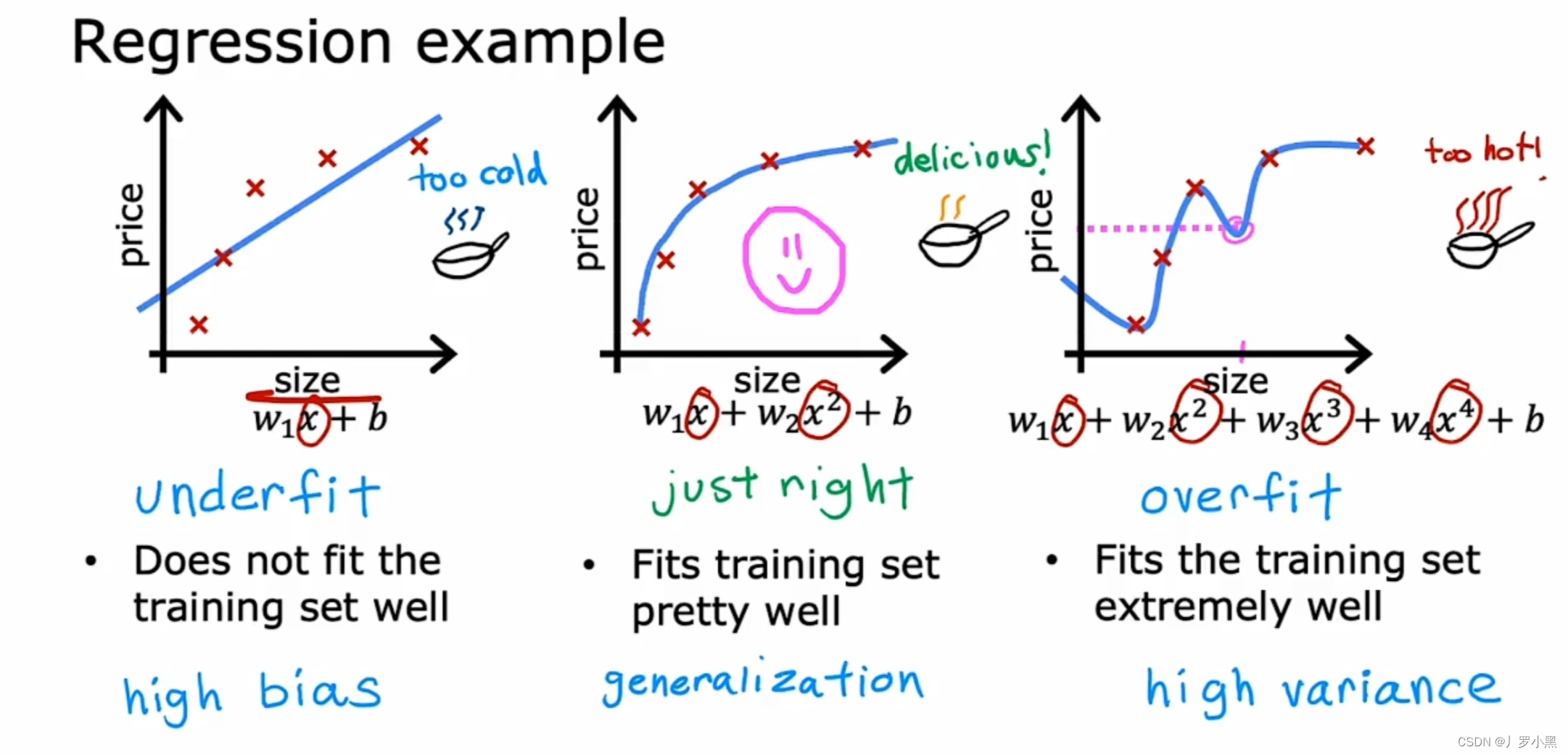

2. 线性回归的过拟合

- 左侧的图片是欠拟合或具有高偏差,这个模型并不能很好的拟合训练数据

- 中间的图片是泛化良好,这个模型能很好的拟合训练数据,但并不是完美拟合训练数据中的每一个训练样本,并能对从未出现的全新示例也能做出良好的预测

- 右侧的图片是过拟合或具有高方差,这个模型具有非常多且复杂的高阶特征,这个模型虽然完美拟合训练数据,但是对从未出现的全新示例无法做出良好的预测

3. 逻辑回归的过拟合

- 左侧的图片是欠拟合或高偏差,这个模型并不能很好的拟合训练数据

- 中间的图片是泛化良好,这个模型能很好的拟合训练数据,但不是完美的拟合训练数据中的每一个训练样本

- 右侧的图片是过拟合或高方差,这个模型具有非常多且复杂的高阶特征,且这个模型能完美拟合训练数据,但对从未出现的全新示例无法做出良好的预测

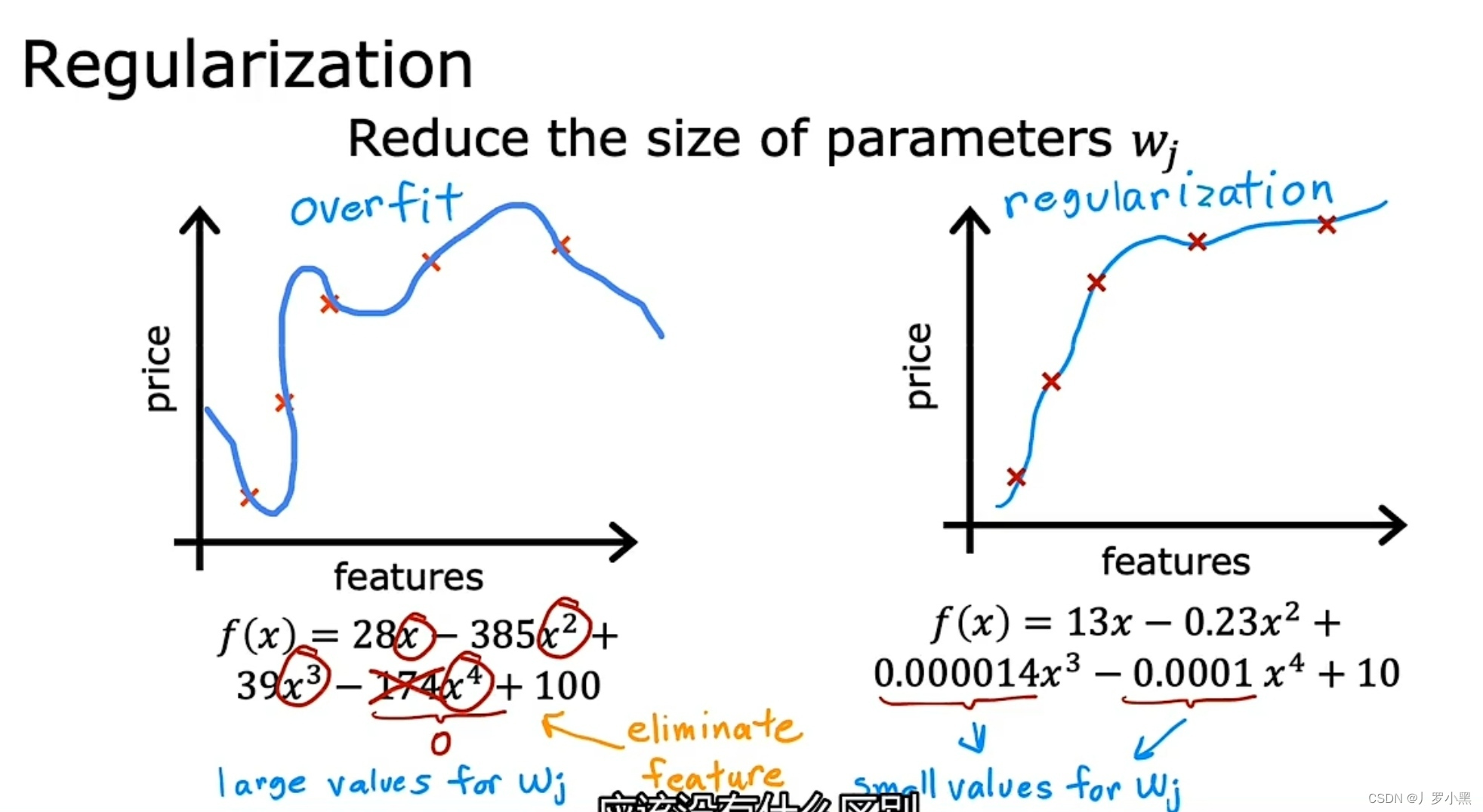

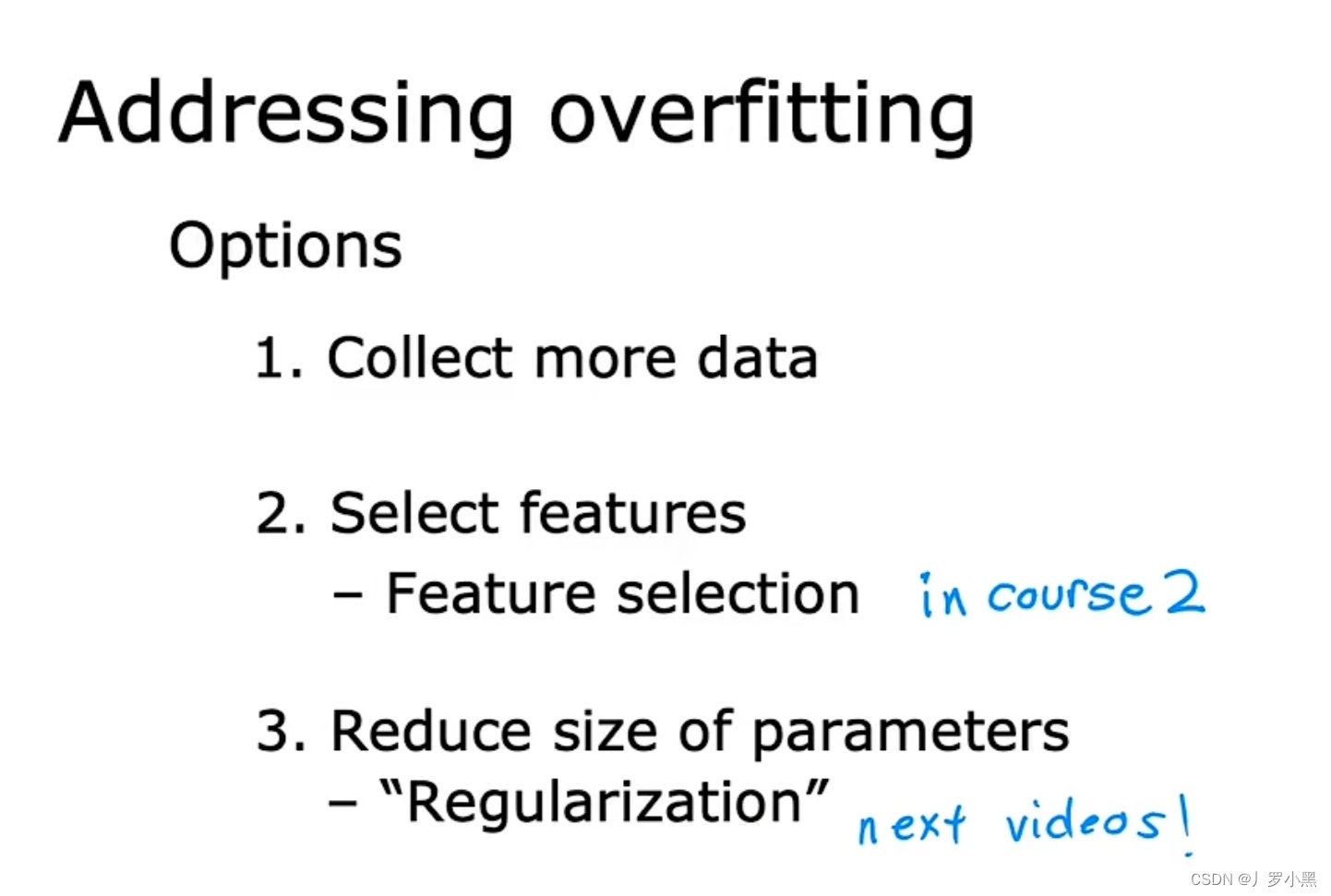

4. 过拟合的解决办法

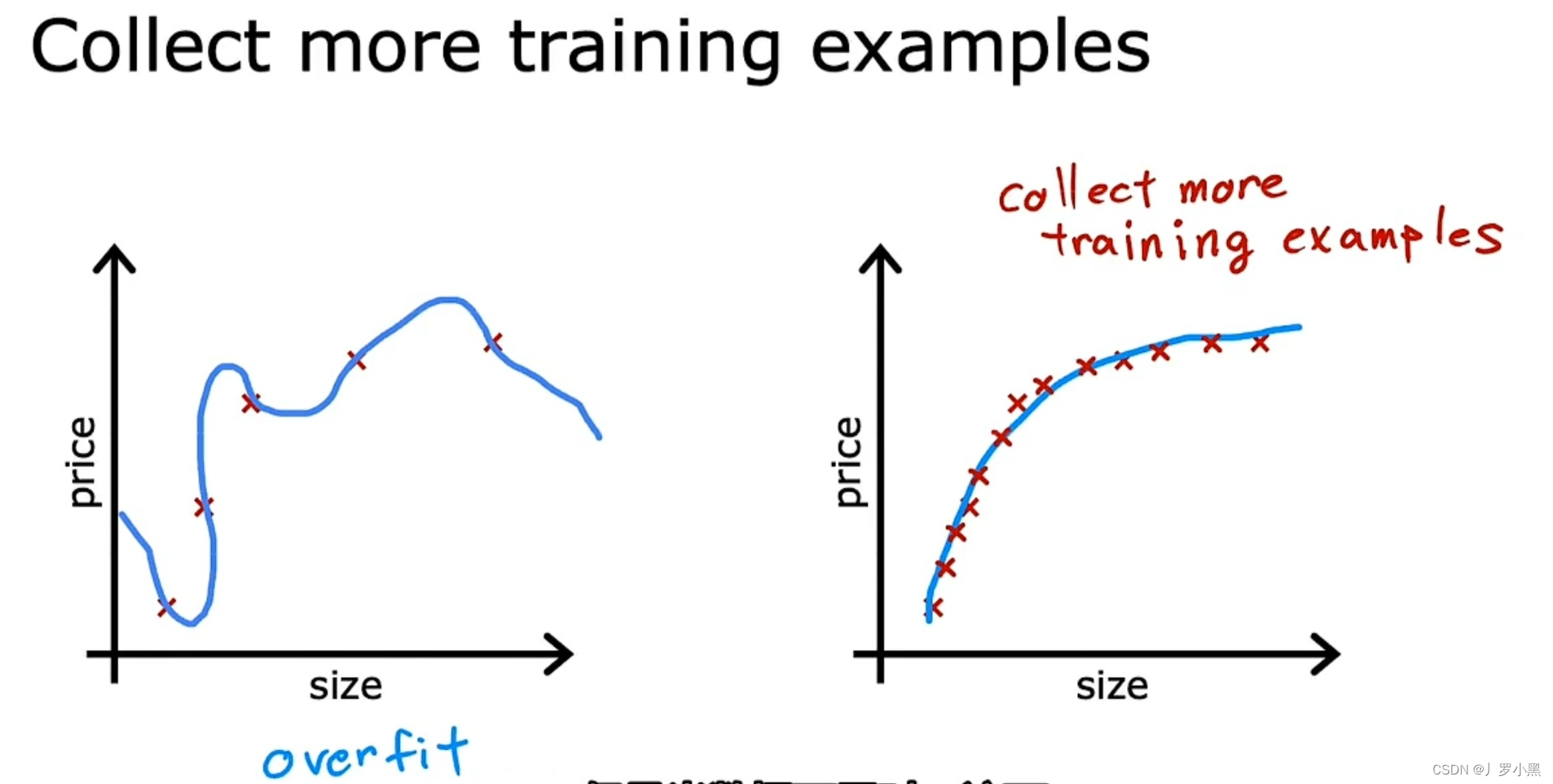

- 第一个方法:收集更多的训练数据,使数据集变得更大,那么模型将变得不会那么高方差

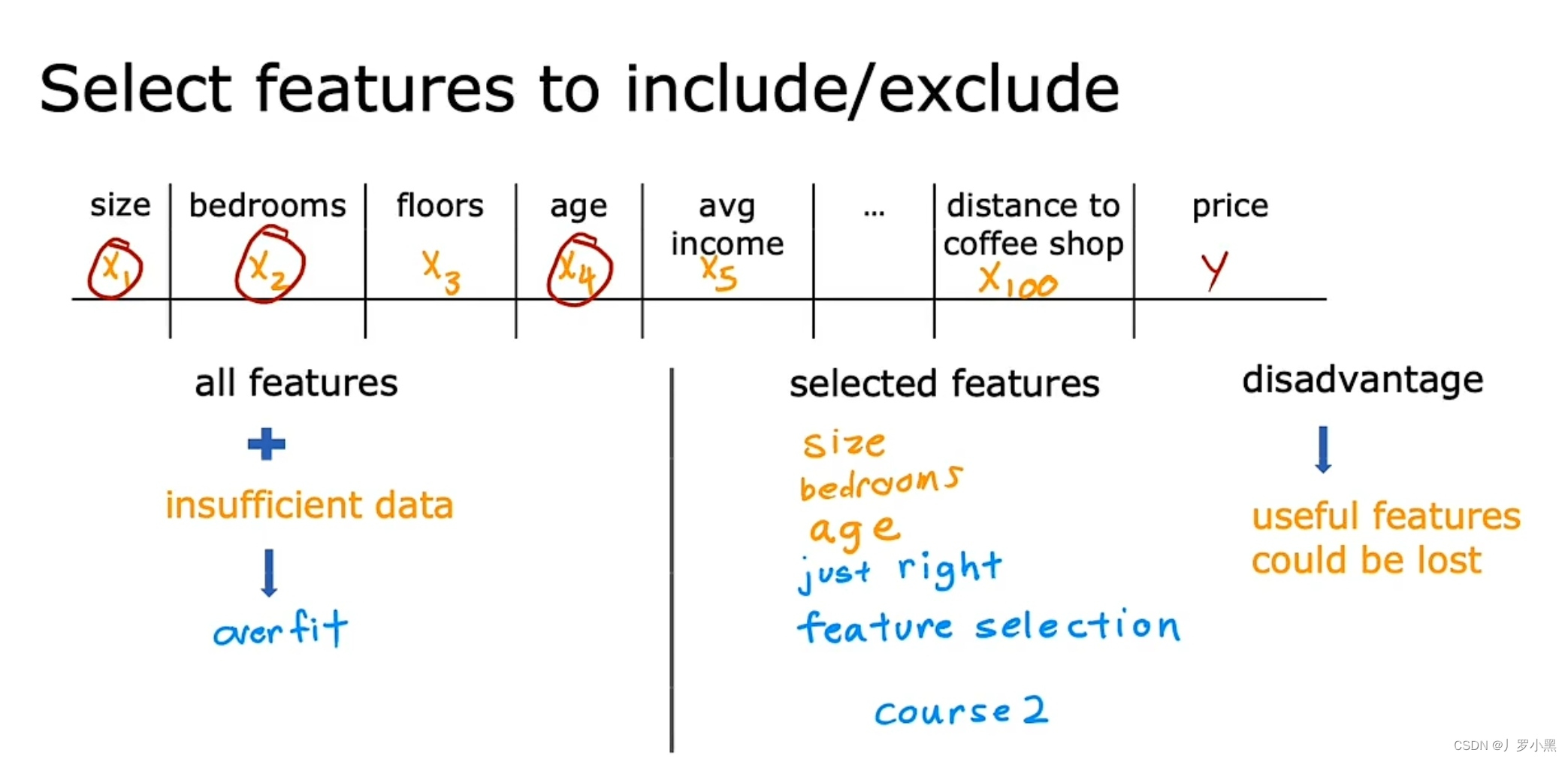

- 第二个方法:特征选择,即减少一些特征(变量)。如果你有很多的特征,但没有足够的训练数据,那么也会导致过拟合。若使用最小的特征子集(即减少一些变量),那么可能就不再过拟合。这个方法以后会讲

- 缺点是:会丢弃有关房屋的一些有用信息

- 第三个方法:正则化,缩小特征的参数,而不是像特征选择那样将特征的参数设置为0。通常,我们只缩小Wj,并不缩小b。

- 优点:保留所有特征(变量),保留有关房屋的所有信息