hive表数据导入mysql出错

在使用sqoop将hive表数据导入到mysql时发生如下错误:

命令:

sqoop export --connect jdbc:mysql://192.168.111.137:3306/test --username root --password 123456 --export-dir /user/hive/warehouse/test.db/score --table score --input-fields-terminated-by ','

ERROR mapreduce.ExportJobBase: Export job failed!

ERROR tool.ExportTool: Error during export:

Export job failed!

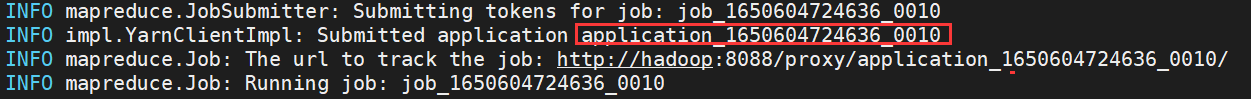

查找application_id,查看错误日志

使用: yarn logs -applicationId application_id 查看log日志

分割符问题:hadoop默认是 \001,将分割符换为 \001 在执行即可

hive安装

Hive官网地址

http://hive.apache.org/

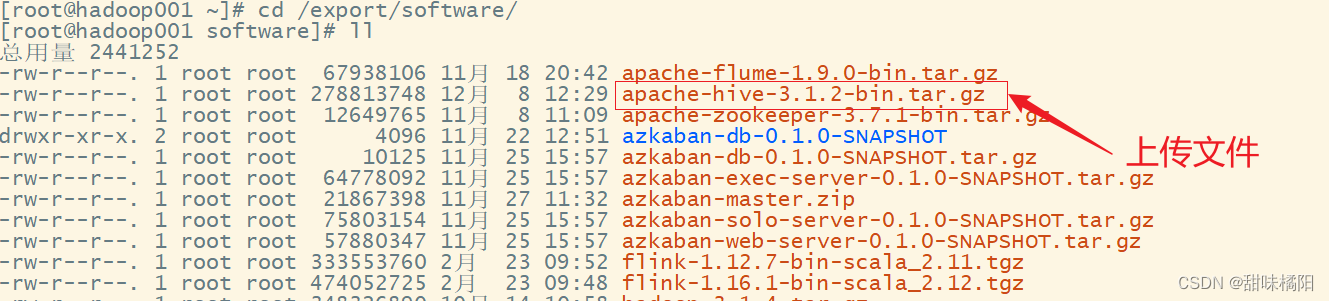

把 apache-hive-3.1.2-bin.tar.gz上传到Linux的/export/software目录下

修改apache-hive-3.1.2-bin.tar.gz的名称为hive

修改/etc/profile,添加环境变量

配置Hive元数据存储到MySQL

1)新建Hive元数据库

#登录MySQL

mysql -uroot -p123456

#创建Hive元数据库

mysql> create database metastore;

mysql> quit;

将MySQL的JDBC驱动拷贝到Hive的lib目录下

在$HIVE_HOME/conf目录下新建hive-site.xml文件

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- jdbc连接的URL -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/metastore?useSSL=false</value>

</property>

<!-- jdbc连接的Driver-->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- jdbc连接的username-->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- jdbc连接的password -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>root</value>

</property>

<!-- Hive默认在HDFS的工作目录 -->

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

</configuration>

初始化hive元数据

bin/schematool -dbType mysql -initSchema -verbose