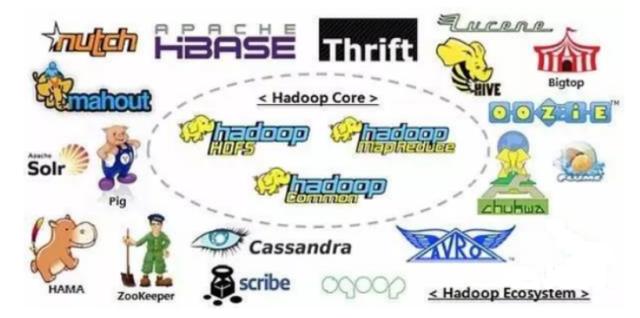

Hadoop是现在最流行的大数据分布式基础架构,其实现了很多大数据相关的核心功能,并且支持大量的核心项目。今天加米谷就给大家盘点一下Hadoop以及Hadoop生态圈。

一、Hadoop内部核心模块

- Hadoop Common:大量低层核心组件和接口,主要用于支持和集成其他模块。

- Hadoop MapReduce:

- Hadoop分布式计算框架,其实现了海量数据高速并行计算,需要基于Yarn。

- Hadoop Distributed File System:

- Hadoop分布式文件系统,也就是我们通常说的HDFS,是海量数据存储和高吞吐的核心基础,所有的计算框架都是基于HDFS的。

- Hadoop Yarn:

- Yarn主要负责协调和分配Hadoop集群中的所有资源(CPU、内存等),所有作业的调度都依赖Yarn。

二、Hadoop生态圈的其他核心组件:

- Hbase:

- 一个基于列的存储的分布式数据库,其数据模型为Key-Value模式,便于扩展并且查询高效。

- Hive:

- Hive是Hadoop提供的一个数据仓库,也提供数据库部分功能。其最大的作用还是简化了编写MapReduce程序的过程,只需要利用SQL语句即可完成MapReduce计算。

- Cassandra:

- Cassandra也是基于列存储的,但是其数据模型为column-based,即一列就是一条数据。它最大的优点就是有多个Master,不会出现单点故障。

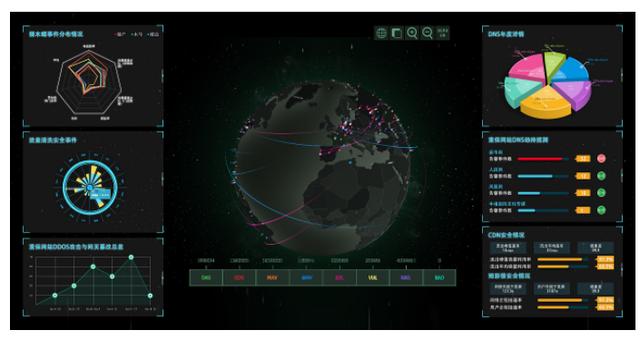

- Ambari:

- Ambari是可视化的检测工具,其低层是基于Web平台的。它可以监控Hadoop,Hive、HBase、Pig等绝大多数工具。并且还能将MapReduce等程序的功能可视化,在线对比其性能。

- Avro:

- Avro是一个将数据序列化的工具,它有着丰富的数据结构类型,提供二进制数据等。并且还支持一点点动态语言。

- Chukwa:

- Chukwa是一个数据收集工具,其监控的对象为大型分布式系统。在节点数量巨大的集群上,就需要用Chukwa来收集集群的相关信息,分析其健康状态。

- Spark:

- Spark是一种更加快速的Hadoop计算引擎,它的运算速度比MapReduce快近百倍。相对的其对内存的要求也更高,因为它是基于内存的。Spark对机器学习也有非常良好的支持。

- Mahout:

- Mahout是Hadoop提供的算法库,经常被用于数据挖掘和机器学习。

- Pig:

- Pig一种过程语言,其主要作用有两点,一是用来对数据进行预处理和转换,以便MapReduce能更好地运行。二是用来处理数据流。

- Tez:

- Tez是一个比较新的分布式执行框架,建立于Yarn的基础之上,功能上与MapReduce有类似之处。目前Hive、pig等框架都在慢慢的采用Tez而抛弃MapReduce了。

- Zookeeper:

- Zookeeper主要负责分布式应用的协作,集群之间的交流和通讯都依靠Zookeeper完成。

以上就是现在最核心Hadoop和Hadoop生态圈的工具,有想学习的小伙伴务请收好。成都加米谷大数据人才培训机构分享。