在使用docker 未果的情况下,无奈采用本地环境搭建。中间有部分坑( 此篇 为64位的环境, 如果是32位 则无需更换bin内容)

准备工作

进行配置

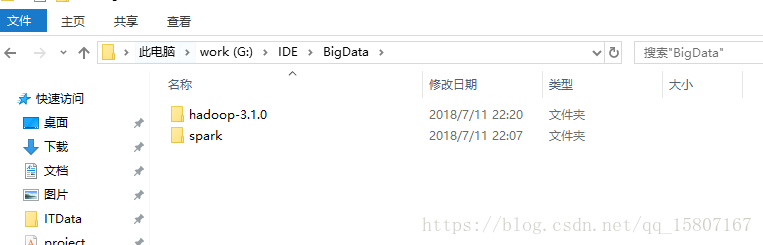

将 下载好的Hadoop 和 Spark进行解压,我进行了重命名 如图1.1

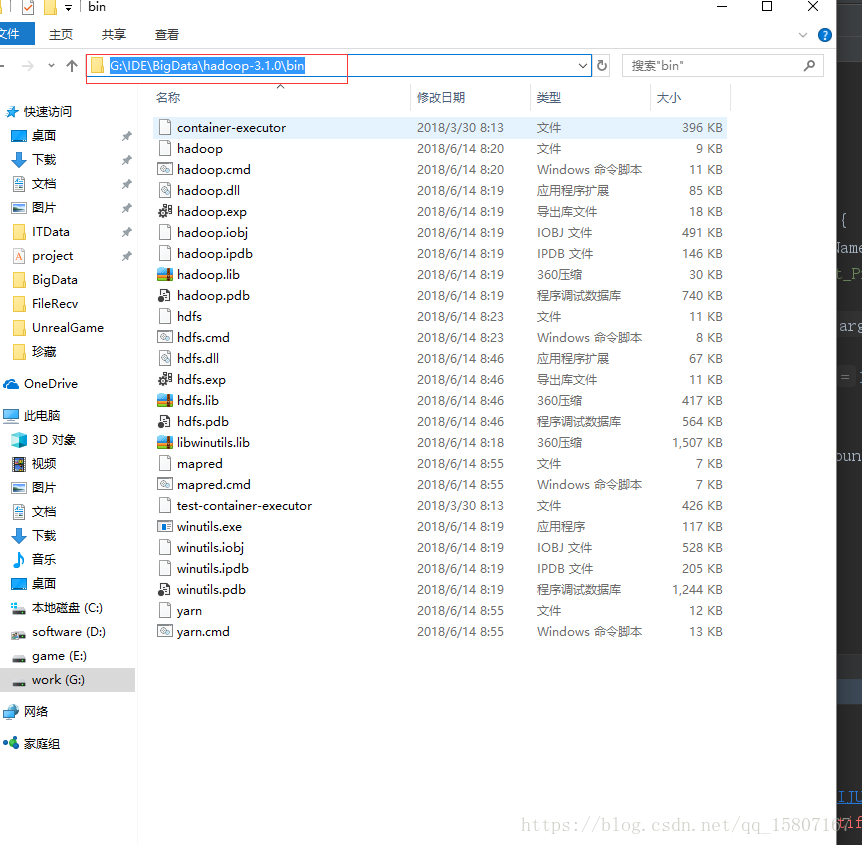

图1.1 将 准备工作中 第一项下载的包进行解压。并进行更换 解压的hadoop3.1.0下的

/bin目录里的文件(如图1.2)

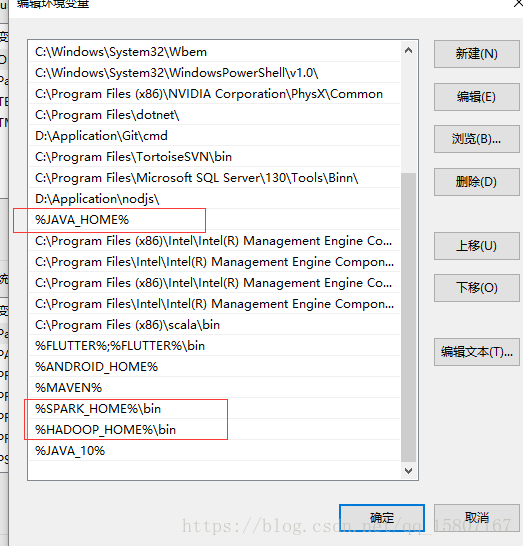

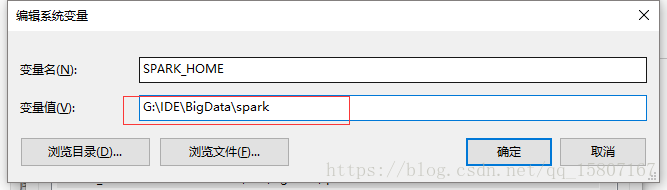

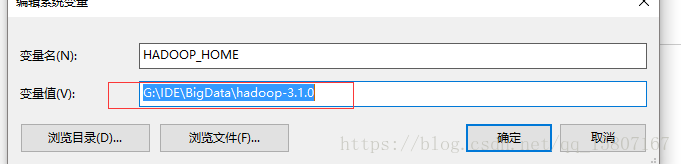

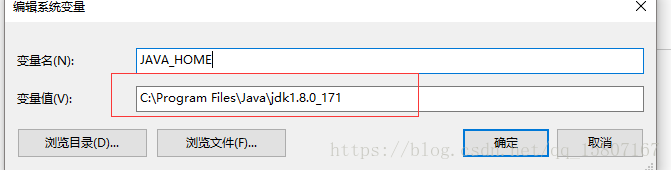

图1.2 进行配置我们需要的环境变量(如图1.3)

图1.3

配置内容如下:

扫描二维码关注公众号,回复:

2166863 查看本文章

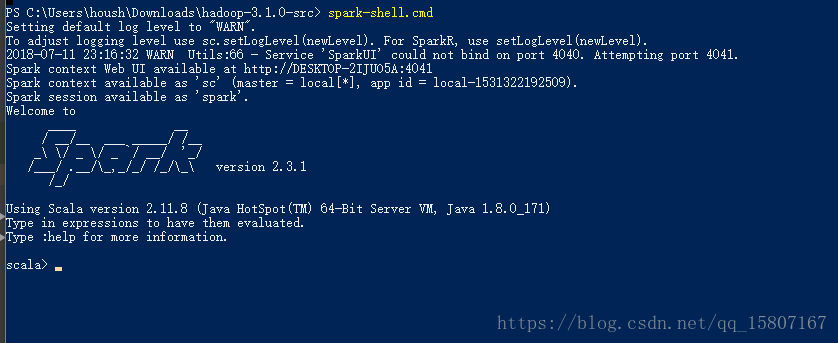

测试

我们进行输入spark-shell 可以看到已经可以正常。并且没有报错内容