1.线性回归的原理:

线性回归在假设特证满足线性关系,根据给定的训练数据训练一个模型,并用此模型进行预测。

2.损失函数:是定义在单个样本上的,算的是一个样本的误差

3.代价函数:是定义在整个训练集上的,是所有样本误差的平均,也就是损失函数的平均。在线性回归中,最常用的是均方误差,在逻辑回归中,最常用的代价函数是交叉熵

4.目标函数:最终需要优化的函数。等于经验风险+结构风险(也就是CostFunction+正则化项)

关于目标函数和代价函数的区别还有一种通俗的区别:

目标函数是最大化或者最小化,而代价函数是最小化

5.优化方法:

○梯度下降法:他通过每次在当前梯度方向(最陡峭的方向)向前“迈”一步,来逐渐逼近函数的最小值。梯度下降法根据每次求解损失函数带入的样本数,可以分为:全梯度下降(计算所有样本的损失),批量梯度下降(每次计算一个batch样本的损失)和随机梯度下降(每次随机选取一个样本计算损失)。现在所说的SGD(随机梯度下降)多指批量梯度下降。SGD的优点是操作简单,计算量小,在损失函数是凸函数的情况下能够保证收敛到一个较好的全局最优解,缺点是①α是一个定值(在最原始的版本),他的选取直接决定了解得好坏,过小会导致收敛太慢,过大会导致震荡而无法收敛到最优解②对于非凸问题,只能收敛到局部最优,并且没有任何拜托局部最优的能力

○牛顿法:牛顿法不仅使用了一阶导信息,同时还利用了二阶导来更新参数。牛顿法具有二阶收敛性,每一轮迭代会让误差的数量级呈平方衰减。牛顿法的优点是二阶收敛,收敛速度快,缺点是牛顿法是一种迭代算法,每一步都需要求解目标函数的Hessian矩阵的逆矩阵,计算比较复杂

○拟牛顿法:拟牛顿法的本质洗饲昂视改善牛顿法每次需要求解复杂的Hessian矩阵的逆矩阵的缺陷,他使用正定矩阵来近似Hessian矩阵的逆,从而简化了元素的复杂度。

○共轭梯度法:共轭梯度法是介于最速下降法和牛顿法之间的一个方法,他仅需利用一阶导数信息,但克服了最速下降法收敛慢的缺点,又避免了牛顿法需要存储和计算Hesse矩阵并求逆的缺点,共轭梯度法不仅是解决大型线性方程最有用的方法之一,也是解大型肥西那行最优化最有效的算法之一

6.线性回归评估指标:

a.均方误差(MES):真实值-预测值然后平方之后求和平均

b.均方根误差(RMES)

c.平均绝对误差(MAE)

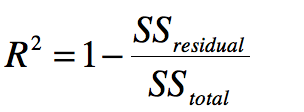

d.RSquared