1.注册中国大学MOOC

2.选择北京理工大学嵩天老师的《Python网络爬虫与信息提取》MOOC课程

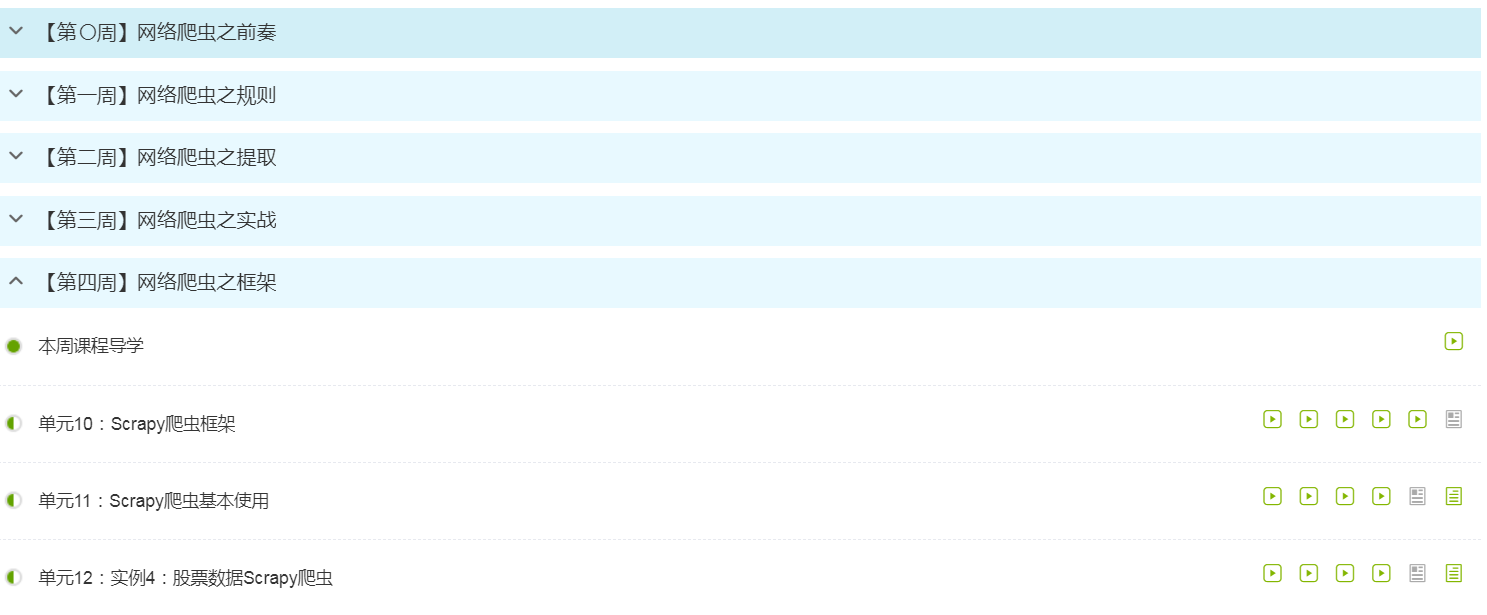

3.学习完成第0周至第4周的课程内容,并完成各周作业

过程。

过程。

5.写一篇不少于1000字的学习笔记,谈一下学习的体会和收获。

通过学习python网络爬虫与信息提取,对于python的了解更多了,这个网课上的很详细,老师讲的也很细致。通过这个课程我也知道了很多以前没有接触到的知识,我知道了什么是网络爬虫以及爬虫有什么作用,我都有去做了下功课。网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。爬虫可以作为通用搜索引擎网页收集器,做垂直搜索引擎,并且科学研究:在线人类行为,在线社群演化,人类动力学研究,计量社会学,复杂网络,数据挖掘,等领域的实证研究都需要大量数据,网络爬虫是收集相关数据的利器。

Python网络爬虫是可以跨平台,对对Linux和windows都有不错的支持;科学计算,数值拟合:Numpy,Scipy;可视化:2d:Matplotlib(做图很漂亮), 3d: Mayavi2;复杂网络:Networkx;统计:与R语言接口:Rpy。用python写爬虫是为了满足“抓数据”的需求,使用爬虫软件更为方便,不用把时间花在解析网页上、测试程序上以及处理防采集上。

python网络爬虫与信息是有五个框架,每一个都有自己的特点。Requests框架:自动爬取HTML页面与自动网络请求提交;robots.txt:网络爬虫排除标准;BeautifulSoup框架:解析HTML页面;Re框架:正则框架,提取页面关键信息;Scrapy框架:网络爬虫原理,专业爬虫框架介绍。而requests库是目前公认的爬取网页最好的python第三方库,特点是简单。Python网络爬虫的主要方法有很多,其中request()是构造一个请求,是支撑各方法的基础;get()是获取html网页的主要方法,对应的是http的get;head()是获取html网页头的信息方法,对应的是http的head ;post() 是向html网页提交post请求,对应的是http的post;put()是向html网页提交put请求,对应的是http的put;patch()是向html页面提交局部修改请求,对应的是http的patch;而delete()是向html页面提交删除请求,对应的是http的delete。

response对象的属性有五种,r.status_code是http请求返回的状态,200表示链接成功,404表示失败;r.text是http响应内容的字符串形式,即,url对应的页面内容;r.encoding是从http header中获取对应的内容编码形式 ;r.apparent_encoding是从内容中分析的响应内容编码方式;r.content是http响应的内容的二进制形式。

Python的内容多式多样,是学无止境的,要学好这门课程,是需要长时间的钻研,仅仅靠这个课程是远远不够的。在这里面我们学到了很多书本以外的知识,这都是一种收获,老师上的课也都很详细,把每一个知识点都有讲透,并且呈现出来,让我对python的兴趣多了一点。中国大学生慕课也是一个好的平台,能让更多人可以学习,通过这个平台去了解更多的知识,让自己的专业知识更加丰富。