首先把28*28的mnist经过1/3池化变成9*9

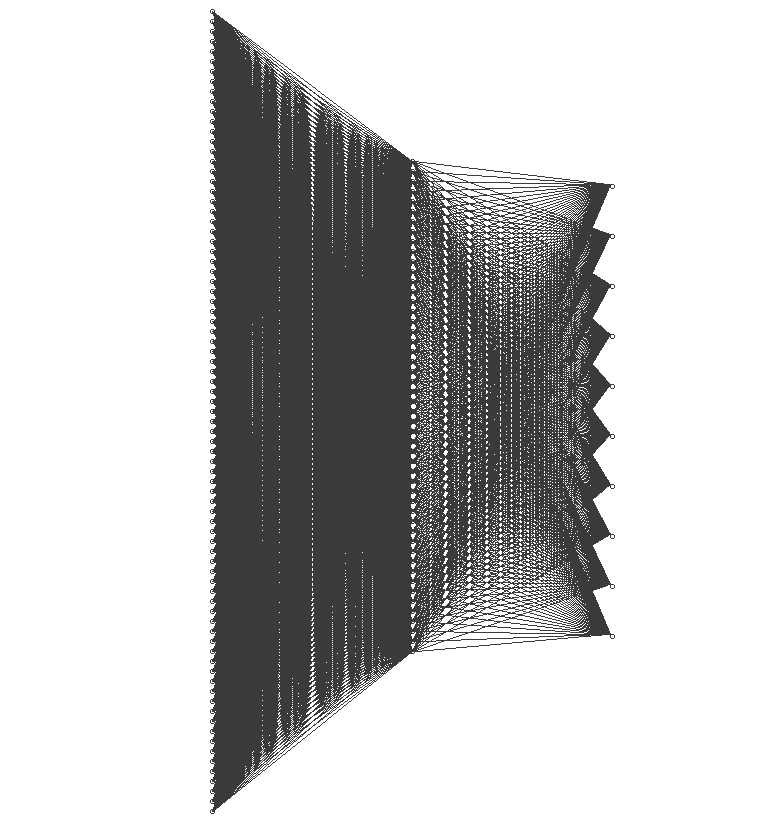

制作一个81*50*10的神经网络用来区分mnist数据集,假设有一束光有81行,无数列,每一列81个强度不一样的光子对应mnist数据集的一幅图片。假设输出为0时第一位显示深红色其他位无色,输出其他数字时也有不同的颜色。

| * | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | |

| 0 | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 深红 |

| 1 | 0 | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 浅红 |

| 2 | 0 | 0 | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 红 |

| 3 | 0 | 0 | 0 | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 橙 |

| 4 | 0 | 0 | 0 | 0 | 1 | 0 | 0 | 0 | 0 | 0 | 黄 |

| 5 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 0 | 0 | 0 | 绿 |

| 6 | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 0 | 0 | 青 |

| 7 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 0 | 蓝 |

| 8 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 紫 |

| 9 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 深紫 |

因为是光速所以我们可以想象如果把输出的颜色投影到墙上应该是一条稳定的彩带。

当然这是经过学习以后的神经网络才可能做到的。

如果这个网络没有经过学习,是一组随机的权重,打到墙上的图像应该有许多种可能,

1. 比如运气好随机选的好正好正是符合要求的权重,可能看到的也是一条彩带

2. 也可能有一个或几个色块

3. 可能有模糊的光亮

4. 也可能什么也没有

总之权重就像分子的概率幅一样开空中飘荡,可能是所有值,也可能不是任何一个值。

但是如果我们强制的让输入1的图像对应

| 0 |

1 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

那这种学习过程同时也就构成了一个测量的行为,可以理解成满足

| 0 |

1 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

的权重被留下了,而不符合这个要求的权重被剔除了。从这个角度来说让神经网络训练的过程类似波函数的坍缩。在我们训练神经网络以前权重可能是任何值,我们的训练行为使波函数坍缩到一点。