Adaptive Deconvolutional Networks for Mid and High Level Feature Learning(deconvnet)

论文简述

本文主要讲述作者通过卷积稀疏编码层和最大池化层交替的层次模型,确保每层都能重构输入,实现了对各种特征结构(如低级边缘、中级边缘连接以及目标的部分高级信息和完整的目标),尤其是中高阶结构,的图像表示的学习。

论文要点

提出问题

- 当前模型多为逐层训练,冲淡了高层和输入之间的连接,使得模型在中高阶结构的表示学习变得不实际。(个人理解,这里针对的是特征结构的表示学习,理解图像而言)

- 不变性是中高层结构建模的关键。

解决方案

switch变量

- 使模型的过滤器局部适应观测数据(模型不变性,使得简单的模型便可捕获图形结构中的广泛变化)

- 提供到输入的直接途径(学习更具有鲁棒性)

- 能够利用有效的训练方法

模型优势

- (top-down生成模型,无监督)vs CNN(自下而上处理且需区别性地,有监督的训练)

分析:该模型的损失函数是最小化重构误差,属于无监督学习 - (层与层之间全连接)vs PSD and DBNs(不同层的特征图之间手动强加稀疏连接)

- 整张图像的分解,超完备图像表示 vs 仅在每个级别而不是所有像素建立稳定的图像结构子集

每张特征图都是超完备图像表示。超完备,类似于用三维坐标表示二维图像。特征图不是仅展现某个级别的结构(如纹理等),而是展现在整个自然图像上。

网络结构

损失函数

最小化对输入图像的重构误差,并将特征图作为稀疏约束项。λl值越大,稀疏度越小。(稀疏度:不包含数据的多维结构的单元的相对百分比)

反卷积

反卷积是稀疏编码的卷积形式,将输入图像分解为合适的特征图Z和滤波器F,两者卷积求和便可以重建原图像。而卷积层是将输入与滤波器进行卷积从而生成特征图。

-

滤波器是所有图像通用的模型参数

将损失函数对fl求导,并使导数等于0,得:

利用线性共轭梯度(CG)进行计算,得到fl的值 -

特征图是针对每个图像的潜在参数(找到使损失函数最小化的特征图)—ISTA模型

- 梯度阶段

求梯度并更新特征图 - 收缩阶段

将特征图中的小值元素都设为0 - 池化&反池化

通过池化,更新switch;再反池化,更新特征图

- 梯度阶段

池化&反池化

采用3D池化操作,且同时记录池化过程中最大值的位置(switches)和值(pooled map),反池化则是将最大值放回到原来的位置,其余位置设为0。

算法详述

每层均通过反卷积及池化获取特征图z,然后再重构原图像,将其与输入图像的误差作为损失函数,求出最佳特征图z以及相应的滤波器f。

- 重构操作:

F表示过滤器,U表示反池化 - 映射操作:

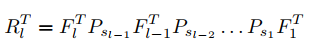

FT表示过滤器的转置,P表示池化

应用处理

- 生成不同图像时采用的switches不同,因此特征图之间没有直接可比性。所以,本文将各层特征图中M个最大刺激分别重构到输入图像上,从而展现出模型生成的特征图对应的不同图像部分。

- 虽然已经证明了稀疏性对于学习高级特征和将图像分解为多个部分的层次结构是有用的,但它不一定是分类的有力线索。

思考

- 本文提出反卷积和switch变量,使得可以重构到图像像素级别,从而实现了无监督的中高阶特征获取。

- 如果之后做相关工程,可以参考方式相似的论文中的实验方法,如预处理等。